introduction

Le nom complet de la matrice de disques est : RedundanArrayofInexpensiveDisk, appelé technologie RAID. Il s'agit d'une technologie de redondance de disques proposée par le professeur David Patterson de l'Université de Californie à Berkeley en 1988. Depuis lors, la technologie des baies de disques s'est développée rapidement et mûrit progressivement. Les gens ont progressivement réalisé la technologie des baies de disques. La technologie des matrices de disques peut être divisée en plusieurs niveaux de technologie RAID 0-5 en détail, et de nouveaux niveaux de niveaux RAID 10, 30, 50 ont été développés. RAID est l'abréviation de Redundant Array of Inexpensive Disk. Les avantages de l'utilisation du RAID sont simplement : une sécurité élevée, une vitesse rapide et une grande capacité de données. Certains niveaux de technologie RAID peuvent augmenter la vitesse à 400 % d'un seul disque dur. La matrice de disques connecte plusieurs disques durs pour qu'ils fonctionnent ensemble, améliorant considérablement la vitesse et améliorant en même temps la fiabilité du système de disque dur à un état presque sans erreur. Ces systèmes « tolérants aux pannes » sont extrêmement rapides et extrêmement fiables.

Du point de vue de la baie de disques

La spécification la plus importante de la baie de disques est la vitesse, c'est-à-dire le type de CPU. Nous savons que l'évolution du SCSI est basée sur le SCSI 2

(Étroit, 8 bits, 10 Mo/s), SCSI 3 (Large, 16 bits, 20 Mo/s), Ultra Wide (16 bits, 40 Mo/s), Ultra 2 (Ultra Ultra Wide, 80 Mo/s), Ultra 3 (Ultra Ultra Ultra Wide, 160 Mo/s), du SCSI aux E/S série, également connu sous le nom de Fibre Channel (FC-AL, Fibre Channel-Arbitration Loop, 100 – 200 Mo/s), SSA (Serial Storage Architecture, 80 – 160 Mo/s) s), lorsque des baies de disques Ultra Wide SCSI, 40 Mo/s étaient utilisées dans le passé, les exigences CPU ne doivent pas être trop rapides, car SCSI lui-même n'est pas bientôt, mais lorsque SCSI évolue vers Ultra 2, 80 Mo/s, le Les besoins en CPU sont très critiques. Le processeur général (tel que 586) doit être remplacé par un processeur RISC haute vitesse (tel que le processeur Intel RISC, i960RD 32 bits, i960RN 64 bits), non seulement le processeur RISC, mais également la différence entre le processeur RISC 32 bits et 64 bits. La différence entre 586 et RISC CPU peut être imaginée ! C'est du point de vue de la matrice de disques.

Du point de vue du serveur

La structure du serveur est passée de la structure d'E/S traditionnelle à la structure I2O (E/S intelligentes, I2O en abrégé), et son objectif est de réduire la charge sur le processeur du serveur séparera les E/S du système de la charge CPU du serveur. Intel propose donc l'architecture I2O, et I2O est également géré par un CPU RISC (i960RD ou I960RN). Imaginez si le processeur RISC i960 est déjà responsable des E/S sur le serveur, mais que le processeur 586 est toujours utilisé sur la baie de disques, la vitesse sera-t-elle plus rapide ?

Du point de vue du système d'exploitation

p>SCO OpenServer 5.0 32 bits

Microsoft Windows NT 32 bits

SCO Unixware 7.x 64 bits

MicroSoft Windows NT 2000 32 bits 64 bits

SUN Solaris 64 bits …….. Autres systèmes d'exploitation

Le système d'exploitation est passé de 32 bits à 64 bits, et le processeur sur la matrice de disques doit être un processeur Intel i960 RISC afin de répondre aux exigences de vitesse. 586 CPU ne suffit pas !

Fonction

La connexion du disque dur dans la matrice de disques utilise-t-elle le fond de panier intégré SCA-II ou utilise-t-elle simplement le câble SCSI ? Y a-t-il une puce d'isolation sur le panneau arrière du SCA-II pour empêcher la haute/basse tension générée par le disque dur lors du branchement à chaud, provoquant un retour de la tension du système, provoquant une instabilité du système et une perte de données.

Nous devons faire attention à ce problème, car de nombreux disques durs de la matrice de disques partagent le même bus SCSI ! Un disque dur remplaçable à chaud ne peut pas affecter d'autres disques durs ! Qu'est-ce que l'échange à chaud ou l'échange à chaud ? Les disques durs sont divisés en disques durs remplaçables à chaud, les disques durs à 80 broches sont des disques durs remplaçables à chaud, les disques durs à 68 broches ne sont pas des disques durs remplaçables à chaud, qu'il y ait une connexion à chaud, la différence dans la conception des circuits réside dans il y a une conception de circuit de protection, la même Le plateau de disque dur est le même, il y a une différence entre un vrai échange à chaud et un faux échange à chaud.

Existe-t-il des conditions de commande pour les disques durs de la matrice de disques ? C'est-à-dire, les disques durs peuvent-ils être réinsérés dans le réseau dans le désordre, et les données sont-elles toujours accessibles normalement ? Beaucoup de gens pensent que ce n'est pas très important et qu'il est peu probable que cela se produise, mais si cela peut arriver, nous devons empêcher que cela se produise.

Si vous utilisez six disques durs comme matrice, lors de l'initialisation initiale, les six disques durs sont placés dans la matrice de disques dans l'ordre, divisés du premier, du deuxième... au sixième disque dur. Il y a une commande. Si la matrice de disques que vous achetez nécessite une commande, vous devez faire attention : un jour, vous retirez le disque dur et vous devez le réinsérer dans la matrice de disques dans l'ordre d'origine lors du nettoyage, sinon vos données Les données peuvent être perdues car la séquence du disque dur n'est pas la même que celle d'origine et le contrôleur de la matrice de disques ne la reconnaît pas ! Parce que le numéro d'identification SCSI de votre disque dur est erroné. Les produits de matrice de disques ont ce genre de fonction qui ne nécessite pas l'ordre des disques durs. Afin d'éviter l'occurrence des événements mentionnés ci-dessus, l'ordre des disques durs n'est pas requis.

Nous discuterons de ces nouvelles technologies, ainsi que des avantages et inconvénients des différents niveaux de RAID. Nous ne voulons pas impliquer les détails techniques clés, mais présenter les baies de disques et les technologies RAID à des personnes qui ne les connaissent pas. Je pense que cela vous aidera à choisir la bonne technologie RAID.

Huit séries

Les huit séries suivantes ont été essentiellement reconnues.

RAID0 (matrice de disques de niveau 0)

RAID0 est également appelé partitionnement des données, c'est-à-dire que les données sont distribuées sur plusieurs disques sans mesures de tolérance aux pannes. Sa capacité et son taux de transfert de données sont N fois la capacité d'une seule machine. N est le nombre total d'unités de disque qui constituent la matrice de disques. Le taux de transfert d'E/S est élevé, mais le temps moyen avant défaillance (MTTF) (MeanTimeToFailure) n'est que d'un Nième de celui d'un seul lecteur de disque. Par conséquent, la fiabilité de la matrice de disques de niveau zéro est la pire.

RAID1 (matrice de disques de niveau 1)

RAID1, également connu sous le nom de disque miroir, utilise la tolérance aux pannes de mise en miroir pour améliorer la fiabilité. C'est-à-dire que chaque disque de travail a un disque miroir. Lors de l'écriture de données, elles doivent être écrites sur le disque miroir en même temps. Lors de la lecture des données, elles ne sont lues qu'à partir du disque de travail. Une fois que le disque de travail tombe en panne, transférez immédiatement sur le disque miroir, lisez les données à partir du disque miroir, puis le système restaurera les données correctes sur le disque de travail.

Par conséquent, les données peuvent être reconstruites de cette manière, mais le disque de travail et le disque miroir doivent maintenir une correspondance un à un. Ce type de baie de disques est très fiable, mais sa capacité effective est réduite à moins de la moitié de la capacité totale. Par conséquent, RAID1 est souvent utilisé dans des applications qui nécessitent des taux d'erreur extrêmement stricts, telles que la finance et la finance.

RAID2 (matrice de disques de niveau 2)

RAID2 est également appelé entrelacement de bits. Il utilise le code Hamming pour la vérification des erreurs de disque, sans avoir besoin d'une vérification CRC (CyclicReDundancycheck) après chaque secteur. Le code de Hamming est un code de bloc linéaire (n, k), n est la longueur du mot de code, k est le nombre de bits de données et r est le nombre de bits utilisés pour la vérification, donc : n=2r-1r=n- k< /p>

L'entrelacement au niveau du bit est donc le plus avantageux pour la vérification du code de Hamming. Ce disque est adapté à la lecture et à l'écriture de données volumineuses. Cependant, la surcharge des informations redondantes est encore trop importante, ce qui empêche une large application de tels disques.

RAID3 (matrice de disques de niveau 3)

bitsCN~com

RAID3 est un disque de matrice de transmission parallèle tolérant aux pannes à un seul disque. Sa caractéristique est de réduire le disque de contrôle à un (le disque de contrôle RAID2 est multiple, le disque de contrôle DAID1 est 1:1), et les données sont stockées dans chaque disque sous forme de bits ou d'octets (le même numéro de secteur est dispersé et enregistrés dans le groupe. Sur chaque machine à disque). Son avantage est que la bande passante de l'ensemble de la baie peut être pleinement utilisée pour réduire le temps de transmission des données par lots ; son inconvénient est que chaque lecture et écriture doit affecter l'ensemble du groupe et ne peut être effectuée qu'une fois à chaque fois

RAID4 (matrice de disques de niveau 4)

RAID4 est une matrice qui peut lire et écrire indépendamment sur chaque disque du groupe. Il n'y a qu'un seul disque de vérification.

La différence entre RAID4 et RAID3 est la suivante : RAID3 est entrelacé par bit ou octet, tandis que RAID4 est accessible par bloc (secteur), qui peut fonctionner sur un certain disque individuellement, il n'a pas besoin de Comme RAID3, même si chaque petite opération d'E/S implique l'ensemble du groupe, seuls deux lecteurs de disque du groupe (un disque de données et un disque de test) sont impliqués. Améliorant ainsi le taux d'E/S d'une petite quantité de données.

RAID5 (matrice de disques de niveau 5)

RAID5 est une matrice avec accès indépendant à la parité tournante. La différence entre celui-ci et les matrices de disques RAID1, 2, 3 et 4 est qu'il n'a pas de disque à parité fixe, mais distribue ses informations de parité redondantes uniformément sur tous les disques appartenant à la matrice selon une certaine règle. . Par conséquent, il existe à la fois des informations sur les données et des informations de vérification sur le même lecteur de disque. Ce changement résout le problème de conflit de disque de parité, de sorte que plusieurs opérations d'écriture sont autorisées dans le même groupe en RAID5. Par conséquent, RAID5 convient non seulement aux opérations de gros volume de données, mais également à divers traitements de transactions. Il s'agit d'une matrice de disques rapide, de grande capacité et tolérante aux pannes avec une distribution raisonnable.

RAID6 (matrice de disques de niveau 6)

bitsCN~com

RAID6 est une matrice de disques à accès indépendant à double vecchio et même parité. Ses informations redondantes de détection et de correction d'erreurs sont réparties uniformément sur tous les disques, tandis que les données sont toujours stockées dans des blocs entrelacés dans des blocs de taille variable. Ce type de baie de disques peut tolérer des erreurs de double disque.

RAID7 (matrice de disques de niveau 7)

RAID7 est basé sur RAID6 et adopte la technologie de cache, qui améliore considérablement le taux de transmission et la vitesse de réponse. Le cache est une sorte de mémoire tampon à grande vitesse, c'est-à-dire que les données sont écrites dans le cache avant d'être écrites dans la matrice de disques. Généralement, la taille du bloc de cache est la même que la taille du bloc de données dans la matrice de disques, c'est-à-dire qu'un bloc de cache correspond à un bloc de disque. Lors de l'écriture, les données sont écrites dans deux caches indépendants, de sorte que même si l'un des caches tombe en panne, les données ne seront pas perdues. L'opération d'écriture répondra directement au niveau du cache, puis ira à la matrice de disques. Lorsque les données sont écrites du cache sur la matrice de disques, les données de la même piste seront complétées en une seule opération, ce qui évite le problème des écritures multiples de nombreux blocs de données et améliore la vitesse. Lors de la lecture, l'hôte lit également directement à partir du cache au lieu de lire à partir du disque de matrice, ce qui réduit le nombre d'opérations de lecture avec le disque, de sorte que la bande passante du disque est pleinement utilisée.

Cette combinaison de technologie de cache et de matrice de disques compense les lacunes de la matrice de disques (telles qu'une mauvaise réponse aux demandes d'écriture de bloc), de sorte que l'ensemble du système est efficace, rapide, de grande capacité, haute fiabilité et flexibilité , Stockage pratique système est fourni aux utilisateurs, répondant ainsi aux besoins du développement technologique actuel, en particulier les besoins des systèmes multimédias.

S'étendre

Spanning des données (Spanning)

La technologie de répartition des données permet à plusieurs disques durs de fonctionner comme un seul disque dur, ce qui permet aux utilisateurs de combiner certaines ressources ou d'augmenter certaines ressources pour dépasser à moindre coût les limitations d'espace disque existantes.

La figure 2 montre quatre disques durs de 300 mégaoctets connectés ensemble pour former un système SCSI. Au lieu de voir C, D, E, F, 4 disques durs de 300 mégaoctets, l'utilisateur ne voit qu'un seul lecteur C de 1200 mégaoctets. Dans un tel environnement, l'administrateur système n'a pas à s'inquiéter d'une situation où l'espace de contrôle de sécurité du disque dur est insuffisant sur un certain disque dur. Parce que maintenant la capacité de 1200 mégaoctets se trouve sur un seul volume (par exemple, le disque dur C). L'administrateur système peut établir en toute sécurité n'importe quel niveau de système de fichiers requis, sans avoir besoin de planifier son système de fichiers sous les contraintes de plusieurs environnements de disques durs distincts. L'étendue des données du disque dur n'est pas un RAID en soi, et elle ne peut pas améliorer la fiabilité et la vitesse du disque dur. Mais il a l'avantage que plusieurs petits disques durs peu coûteux peuvent être ajoutés au sous-système de disque dur selon les besoins.

Entrelacement du disque dur

(entrelacement de disque, RAID 0)

La méthode d'entrelacement du disque dur écrit les données sur plusieurs disques durs au lieu d'un seul Sur le disque, cela s'appelle également RAID O. Dans le sous-système de réseau de disques, les données sont écrites sur plusieurs disques durs dans l'unité de « segment » spécifiée par le système . Par exemple, le segment de données 1 est écrit sur le disque dur.

0, le segment 2 est écrit sur le disque dur 1, le segment 3 est écrit sur le disque dur 2, et ainsi de suite. Lorsque les données sont écrites sur le dernier disque dur, l'écriture recommence à partir du prochain segment disponible du disque 0, et tout le processus d'écriture des données est répété jusqu'à ce que les données soient écrites. Les segments sont constitués de blocs et les blocs sont constitués d'octets. Par conséquent, lorsque la taille du segment est de 4 blocs et que le bloc est composé de 256 octets, la taille du segment est égale à 1024 octets sur la base de la taille des octets. Les premiers à 1024 octets sont écrits sur le disque 0, les 1025 à 2048 octets sont écrits sur le disque 1, et ainsi de suite. Si notre sous-système de disque dur a 5 disques durs et que nous voulons écrire 20 000 octets, les données seront stockées comme le montre la figure 3.

En bref, comme la méthode de segmentation du disque dur consiste à écrire (lire) des données sur plusieurs disques durs à la fois, sa vitesse est relativement rapide. En fait, la transmission des données est séquentielle, mais plusieurs opérations de lecture (ou d'écriture) peuvent se chevaucher. C'est-à-dire que juste au moment où le segment 1 écrit sur le lecteur 0, l'opération d'écriture du segment 2 sur le lecteur 1 commence également ; alors que le segment 2 est toujours en train d'écrire sur le lecteur 1, les données du segment 3 ont été envoyées au lecteur 2 ; et ainsi de suite, dans Plusieurs disques (même si tous les disques) écrivent des données en même temps. Parce que la vitesse à laquelle les données sont envoyées au lecteur de disque est beaucoup plus rapide que la vitesse à laquelle elles sont écrites sur le disque physique. Par conséquent, tant que le logiciel de commande est compilé selon cette caractéristique, l'opération d'écriture de données mentionnée ci-dessus peut être réalisée en même temps.

Malheureusement, le RAID 0 ne fournit pas de données redondantes, ce qui est très dangereux. Étant donné que l'ensemble du sous-système du disque dur doit être assuré pour fonctionner correctement, la calculatrice peut fonctionner normalement. Par exemple, si un fichier a le segment 1 (dans le lecteur 0), le segment 2 (dans le lecteur 1) et le segment 3 (dans le lecteur 2), alors tant que le lecteur Si l'un des 0, 1, 2 échoue, il causer des problèmes; si le lecteur 1 tombe en panne, nous ne pouvons obtenir physiquement que les données des segments 1 et 3 du lecteur. Heureusement, une solution peut être trouvée, qui est la segmentation du disque dur et la redondance des données. Cette question sera discutée dans la sous-section suivante.

Mise en miroir du disque dur

La mise en miroir du disque dur (RAID 1) est la forme la plus traditionnelle de technologie de matrice de disques à tolérance de pannes. Il est relativement connu dans l'industrie. Son avantage le plus important est la redondance des données à 100 %. RAID 0 réalise la redondance des données en copiant simplement toutes les données d'un disque sur le deuxième disque (ou un périphérique de stockage équivalent). Bien que cette méthode soit simple et relativement facile à mettre en œuvre, elle présente des inconvénients Elle est deux fois plus chère qu'un seul disque dur non redondant, car un autre disque dur doit être acheté en miroir du premier disque dur.

La forme la plus simple de mise en miroir de disque dur est réalisée en connectant deux disques durs à un contrôleur. La figure 4 illustre la mise en miroir du disque dur. Lorsque des données sont écrites sur un certain disque dur, elles sont écrites en même temps sur le disque miroir correspondant. Lorsqu'un lecteur de disque tombe en panne, le système de calculatrice peut toujours fonctionner car il peut manipuler les données sur le bon disque restant.

Étant donné que les deux disques sont des images miroir l'un de l'autre, peu importe quel disque tombe en panne. Deuxièmement, le disque contient les mêmes données à tout moment, et n'importe lequel peut être utilisé comme disque de travail. Dans la méthode RAID simple de mise en miroir du disque dur, certaines méthodes d'optimisation de la vitesse peuvent toujours être utilisées, telles que l'équilibrage de la charge des demandes de lecture. Lorsque plusieurs utilisateurs demandent des données en même temps, la demande de lecture de données peut être répartie sur les deux disques durs, de sorte que la charge de lecture soit répartie uniformément sur les deux disques durs. Cette méthode améliore considérablement les performances de lecture des données, car deux disques durs lisent des données différentes en même temps. Mais la mise en miroir du disque dur ne peut pas améliorer les performances d'écriture des données. Le disque dur « mis en miroir » peut également être mis en miroir sur d'autres périphériques de stockage, tels qu'un lecteur optique réinscriptible. Bien que la vitesse d'utilisation d'un disque optique comme disque miroir ne soit pas aussi rapide que celle d'un disque dur, cette méthode réduit la perte de données par rapport à l'absence de disque miroir. Le danger.

En bref, le système de mise en miroir a de très bonnes performances de tolérance aux pannes et peut augmenter la vitesse de lecture des données ; son inconvénient est qu'il nécessite des disques durs doubles, donc le prix est plus élevé.

Redondance de segmentation

(RAID2~5)

La segmentation du disque dur améliore les performances du sous-système de disque dur, car la vitesse de lecture et d'écriture des données sur le disque dur est Le nombre de disques durs dans le sous-système de disque dur augmente proportionnellement, mais son inconvénient est que la défaillance de tout disque dur dans le sous-système du disque dur entraînera la défaillance de l'ensemble du système informatique. L'ensemble du sous-système de disque dur segmenté peut être mis en miroir. Si 4 disques durs ont été utilisés pour la segmentation, nous pouvons ajouter 4 autres disques durs segmentés comme une image miroir des 4 disques durs d'origine. Évidemment, cela coûte cher (bien que cela puisse être moins cher que la mise en miroir d'un gros disque dur coûteux). Vous pouvez utiliser d'autres données au lieu de mettre en miroir

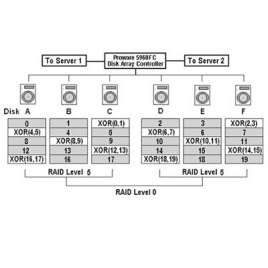

redondance pour fournir une haute tolérance aux pannes. Vous pouvez choisir un mode de code égal magique pour réaliser la méthode ci-dessus, vous pouvez ajouter un disque dur dédié à la parité (comme dans RAID 3), ou vous pouvez distribuer les données de parité sur tous les disques durs de la matrice de disques. Un exemple de données de parité distribuées (RAID 5) est illustré à la Figure 5.

Quel que soit le niveau de RAID utilisé, la matrice de disques utilise toujours une opération OU exclusif (XOR) pour générer des données de parité. Lorsqu'un disque dur du sous-système tombe en panne, l'opération OU exclusif est également utilisée pour reconstruire les données. Ce qui suit analyse brièvement le fonctionnement de XOR.

Disque dur Disque de parité ABC (le résultat du XOR de A, B, C)

Données 1 0 1 0

Rappelez-vous d'abord que dans l'opération XOR, 2 Lorsque le résultat du OU exclusif des nombres est vrai (c'est-à-dire "1"), l'un des deux nombres est 1 (l'autre est 0). Nous supposons que le disque B de A, B et C est défectueux. À ce stade, nous pouvons XOR A, C et les données de parité pour obtenir les données 0 perdues sur le disque B. De même, si le disque C tombe en panne, nous pouvons comparer les disques A, B et la parité. XOR les données pour obtenir les données d'origine 1 du lecteur C.

S'il est étendu au sous-système de disque dur de 7 disques :

Le bit de parité ABCDEF du disque dur

Données 0 0 0 1 0 1 0

Si les données sur le disque B sont perdues, nous pouvons XOR A, C, D, E, F et le bit de parité pour obtenir les données perdues du disque B 0. Et XOR A, B, C, D, E, F et le bit de parité peut récupérer les données 1 du disque D.

En utilisant un disque de parité dédié (comme décrit ci-dessus, RAID 3), lorsque plusieurs opérations d'écriture se produisent en même temps, chaque opération doit écrire sur le disque de parité. Cela produira un effet de goulot d'étranglement d'E/S.

RAID 5 disperse les informations de parité sur tous les disques durs du sous-système de disque dur (au lieu d'utiliser un disque de parité dédié 0, ce qui améliore l'effet de goulot d'étranglement du disque de parité dans le RAID 3 ci-dessus. Figure 5 Décrit une configuration de RAID 5. Le les informations de parité de la figure sont dispersées sur chaque disque dur du sous-système. Une partie de chaque disque dur est utilisée pour former un disque de parité, et les informations de parité écrites sur le disque dur seront réparties plus uniformément sur tous les disques durs. l'utilisateur peut écrire un de ses segments de données sur le disque dur A et les informations de parité sur le disque dur B, et le deuxième utilisateur peut écrire des données sur le disque dur C et les informations de parité sur le disque dur D. De là aussi, on peut voir que le les performances de RAID 5 seront améliorées.

Cette méthode augmentera la vitesse de traitement des transactions du sous-système de disque dur. Le traitement dit des transactions fait référence au traitement de nombreux utilisateurs différents

Opérations d'E/S de disque dur multiples, car il peut y avoir de nombreux utilisateurs traitant le disque dur en même temps, écrivant des données sur le disque dur rapidement, parfois presque en même temps, dans ce cas, l'utilisation d'une méthode de disque à parité distribuée est mieux que d'utiliser un disque de parité dédié, la possibilité d'effet de goulot d'étranglement est faible. Pour le fonctionnement du disque dur, les performances d'écriture de RAID 5 ne sont pas aussi bonnes que celles de la segmentation directe du disque dur (se référant à RAID 0 sans informations de parité). Car générer ou stocker des codes de parité nécessite quelques opérations supplémentaires. Par exemple, lors de la modification de données sur un disque dur, les données du segment correspondant sur d'autres disques (même les données non pertinentes) doivent être lues dans l'hôte pour générer les informations de parité nécessaires. Une fois le segment de parité généré (cela prendra un certain temps), nous devons écrire le segment de données mis à jour et le segment de parité sur le disque dur. C'est ce qu'on appelle généralement une stratégie de lecture-modification-écriture. Par conséquent, bien que RAID 5 soit supérieur à RAID 0, RAID 5 est inférieur à RAID 0 en termes de performances d'écriture. p>

Lorsque la technologie de mise en miroir (RAID 1) et la segmentation de parité des données (RAID 5) sont utilisées dans les sous-systèmes de disque dur mentionnés ci-dessus, des informations redondantes sont générées. Cependant, en RAID 1, toutes les données sont copiées sur les deux premiers disques durs identiques. En RAID 5, le code XOR des données est copié à la place des données elles-mêmes, de sorte que les données peuvent être utilisées dans une représentation très compacte pour récupérer les données perdues en raison d'une panne de disque dur.

< p>Lors de l'utilisation de RAID 5, pour une matrice de 5 disques durs, environ 20 % de l'espace disque est utilisé pour stocker le code de parité, tandis que la matrice de dix disques durs n'a qu'environ 10 % de l'espace pour stocker le code de parité. Le format total dans l'espace disponible En termes d'espace, plus il y a de disques durs dans un système de disques durs, plus le système économisera de l'argent.En bref, le RAID 5 combine les avantages de la technologie de segmentation du disque dur et de redondance de parité. Un tel disque dur Le système est particulièrement adapté aux environnements de traitement des transactions, tels que les billetteries de l'aviation civile, les stations de location de voitures, les terminaux du système de vente, etc. Dans certains cas, RAID 1 peut être prioritaire (dans les situations où les données sont écrites plus fréquemment que les données ne sont lues). Mais dans de nombreux cas, RAID 5 fournit une solution qui combine hautes performances, prix bas et sécurité des données.

Récupération d'échec

La mise en miroir et le RAID offrent de nouvelles façons de récupérer les données en cas de panne de disque dur. Comme toutes les parties des données sont redondantes, la validité des données est très élevée (même en cas de panne du disque dur). Un autre avantage important est que le travail de restauration des données n'a pas besoin d'être effectué immédiatement, car le système peut fonctionner normalement en cas de panne du disque dur. Bien entendu, dans ce cas, le système restant n'aura plus de tolérance aux pannes. Pour éviter la perte de données, les données doivent être restaurées avant que le deuxième disque dur ne tombe en panne. Après avoir remplacé le disque dur défaillant, la récupération des données est requise. Dans le système de mise en miroir, il existe une sauvegarde des données sur le disque « miroir », de sorte que le disque dur défaillant (disque dur principal ou disque dur en miroir) peut reconstruire les données via une simple opération de copie de disque dur à disque dur, comme le montre la figure 6. Cette opération de copie est beaucoup plus rapide que la restauration de données à partir d'une bande.

Dans le sous-système de disque dur RAID 5, le disque dur défectueux utilise les informations de code de correction d'erreur (parité) stockées sur le disque dur non défectueux pour reconstruire les données. Les données sur le disque normal (y compris la partie des informations de parité) sont lues et les données perdues par le disque défaillant sont calculées, puis écrites sur le disque nouvellement remplacé. Ce processus est illustré à la figure 7 et il est beaucoup plus rapide que la restauration de données à partir d'une bande.

La conception flexible de la matrice de disques peut être reconfigurée et l'adresse du disque de remplacement peut différer de l'adresse du disque défaillant, comme illustré à la Figure 8. Cette flexibilité facilite le processus d'installation. Le disque de rechange peut même être pré-connecté au système avant que le disque dur ne tombe en panne. Dans ce cas, il devient un disque de sauvegarde prêt à l'emploi. Ce type de disque est généralement appelé « de secours à chaud ».

Performance

Bien que ces deux termes soient liés l'un à l'autre, ils représentent en réalité deux aspects différents de la défaillance d'un disque dur. Fiabilité

fait référence au disque dur. La probabilité de défaillance dans des conditions données. La disponibilité fait référence au temps pendant lequel le disque dur peut être utilisé dans un certain but. En utilisant ces deux termes, nous pouvons voir comment la matrice de disques améliore la fiabilité de notre système de disque dur à près de 100 %. La matrice de disques peut améliorer la fiabilité du système de disque dur. Étant donné que les données d'un disque dur peuvent être reproduites à partir des données d'autres disques durs (tels que RAID 5), il y a peu de chances que l'ensemble du système de disque dur tombe en panne. La fiabilité du sous-système de disque dur est ainsi grandement améliorée.

Le graphique 9 est une comparaison de la fiabilité d'un sous-système de disque dur RAID et d'un seul sous-système de disque dur :

Il faut aussi tenir compte de la disponibilité du système. La disponibilité d'un système à disque dur unique est meilleure que celle d'une matrice de disques sans redondance des données, et la disponibilité d'une matrice de disques redondante est bien meilleure que celle d'un seul disque dur. En effet, la matrice de disques redondante permet à un seul disque dur de tomber en panne et de continuer à fonctionner normalement. De plus, le temps de récupération du système après une panne de disque dur est considérablement réduit (par rapport à la récupération de données à partir d'une bande). Enfin, parce qu'en cas de panne, les données sur le disque dur sont les données au moment de la panne, et le disque dur remplacé contiendra également les données au moment de la panne (par exemple, les données de sauvegarde la veille ). Pour obtenir une tolérance aux pannes complète, les autres composants du sous-système de disque dur de l'ordinateur doivent également être redondants, tels que la fourniture de deux alimentations, ou équipés de deux contrôleurs de disque dur. Sans la redondance d'autres composants, même avec un sous-système de disque dur très fiable, il ne peut toujours pas empêcher complètement la défaillance du système informatique.

Système tolérant aux pannes

Comme mentionné précédemment, le sous-système directement segmenté (RAID 0) peut augmenter considérablement la vitesse de lecture et d'écriture (par rapport à un seul disque dur), car les données sont dispersées sur plusieurs disques durs. en même temps.

La mise en miroir de deux sous-systèmes de disque dur directement segmentés peut effectivement former un sous-système de disque dur rapide entièrement redondant. Un tel sous-système, son opération de disque dur est encore plus rapide que le sous-système de disque dur segmenté direct, car le système peut effectuer deux opérations de lecture en même temps (une opération de lecture pour chaque disque dur), et la vitesse de l'opération d'écriture est différente de celui de non-miroir. Le sous-système de segment est presque le même, car l'écriture de données sur deux disques durs en même temps ne coûte que peu de frais supplémentaires.

Grâce aux concepts que nous avons décrits précédemment, tels que le duplex : (contrôleurs doubles, alimentations doubles, etc.), les problèmes de redondance peuvent être encore améliorés. Les contrôleurs doubles nous permettent également d'obtenir des vitesses de transmission de données plus élevées, car le contrôleur est moins susceptible de devenir un goulot d'étranglement dans les performances du sous-système.

Termes techniques

Mise en miroir de disque : La forme la plus simple de mise en miroir de disque dur est un contrôleur hôte avec deux disques durs qui se reflètent l'un l'autre. Les données sont écrites sur deux disques durs en même temps, et les données sur les deux disques durs sont exactement les mêmes, donc lorsqu'un disque dur tombe en panne, l'autre disque dur peut fournir des données.

Espacement du disque : grâce à cette technologie, plusieurs disques durs ressemblent à un seul grand disque dur ; ce disque virtuel peut stocker des données sur plusieurs disques sur différents disques physiques. Il faut se préoccuper du disque qui contient les données dont il a besoin.

Striping de disque : les données sont stockées sur plusieurs disques. Le premier segment des données est placé sur le disque 0, le deuxième segment est placé sur le disque 1, ... jusqu'à ce que le dernier disque de la chaîne de disques durs soit atteint, puis le segment logique suivant sera placé sur le disque dur 0, et le prochain segment logique sera placé sur le disque 1 , Et ainsi de suite jusqu'à ce que l'opération d'écriture soit terminée.

Duplexage : Il s'agit de l'utilisation de deux contrôleurs pour piloter un sous-système de disque dur. Lorsqu'un contrôleur tombe en panne, l'autre contrôleur contrôle immédiatement le fonctionnement du disque dur. De plus, si le logiciel de contrôleur approprié est écrit, différents disques durs peuvent fonctionner en même temps.

Tolérance aux pannes (tolérance aux pannes) : la machine dotée de la fonction de tolérance aux pannes a la capacité de résister aux pannes. Par exemple, le système de mise en miroir RAID 1 est tolérant aux pannes. Si l'un des disques en miroir tombe en panne, le sous-système de disque dur peut toujours fonctionner normalement.

Adaptateur hôte : il s'agit du composant de contrôle (tel qu'un contrôleur SCSI) qui permet à l'hôte et aux périphériques d'échanger des données.

Hot Fix : fait référence à l'utilisation d'une sauvegarde à chaud de disque dur pour remplacer un disque dur défaillant. Il convient de noter que le disque défaillant n'est pas réellement remplacé physiquement. Le disque utilisé comme sauvegarde à chaud est chargé avec les données d'origine du disque défaillant, puis le système reprend son travail.

Hot Patch : Un système avec sauvegarde à chaud du disque dur qui peut remplacer les disques défaillants à tout moment.

Hot Spare : Le disque dur qui est électriquement connecté au système CPU, qui peut remplacer le disque défaillant dans le système. La différence avec la sauvegarde à froid est que le disque de sauvegarde à froid n'est généralement pas connecté à la machine et que le disque défaillant est remplacé uniquement lorsque le disque dur tombe en panne.

Temps moyen entre les pertes de données (MTBDL-temps moyen entre les pertes de données) : le temps moyen entre les événements de perte de données.

Temps moyen entre pannes (MTBF-Mean Time Between Failure ou MTIF) : temps moyen entre les pannes des équipements.

Réseau redondant RAID de disques peu coûteux : une technologie qui combine plusieurs disques durs bon marché en un sous-système de disque dur rapide et tolérant aux pannes.

Reconstruction ou reconstruction : après la panne d'un disque dur, processus de restauration des données du disque défaillant à partir d'autres données correctes du disque dur et des informations de parité.

Temps de reconstruction : temps requis pour reconstruire les données du disque défaillant.

Un seul grand disque coûteux (SLED-Single Large Cher Disk).

Taux de transfert : fait référence à la vitesse d'accès aux données dans différentes conditions.

Disque virtuel : similaire au stockage virtuel, un disque virtuel est un disque conceptuel et l'utilisateur n'a pas besoin de se soucier du disque physique sur lequel ses données sont écrites. Les disques virtuels s'étendent généralement sur plusieurs disques physiques, mais l'utilisateur ne voit qu'un seul disque.